Nuestras conversaciones con Claude fueron intocables. Hoy la urgencia de las prensas de datos para hacer materias primas de la IA – La nación

Por lo general, hablamos con inteligencia artificial, como si fuera otra persona y, a veces, confiamos en información muy personal. Sin embargo, rara vez dejamos de pensar en lo que sucede con estas conversaciones. Hasta ahora, el estándar lo había usado en una buena parte del sector para entrenar modelos a menos que se le permitiera al usuario. Anthrope fue una excepción: Claude tenía una directiva explícita de no usar las conversaciones de sus clientes privados para este propósito. Esta excepción está rota. La razón es directa y potente: los datos son la materia prima de la IA.

Anthrope acaba de anunciar en su blog oficial Actualice sus condiciones de servicio para los consumidores y su Directiva de protección de datos. Los usuarios de los planes Free, Pro y Max, incluidas las sesiones en el Código Claude, deben aceptar o rechazar explícitamente que sus discusiones se utilizan para capacitar modelos futuros. La compañía ha establecido la fecha límite hasta el 28 de septiembre de 2025 y advirtió que después de esta fecha era la selección de la preferencia continuar usando Claude.

El giro antrópico. El cambio no afecta: los servicios sujetos a términos comerciales son exuberantes, p. Anthrope afirma que la nueva configuración después de la aceptación de las condiciones solo es válida o recuperada para chats y reuniones de código, y que las conversaciones antiguas no se utilizan para modelos de capacitación sin actividad adicional. Es una distinción quirúrgica relevante: los actos de cambio para futuras actividades.

¿Por qué cambia este cambio? Anthrope señala que todos los modelos de lenguaje “entrenan con grandes cantidades de datos” y que las interacciones reales ofrecen señales valiosas para mejorar la capacidad, como el argumento o la corrección del bacalao. Al mismo tiempo, varios especialistas han señalado un problema estructural: el sitio web abierto se agota como una fuente de información fresca y de fácil acceso, de modo que las empresas buscan nuevas rutas de datos para mantener la mejora continua de los modelos. En este contexto, las conversaciones de los usuarios reciben valor estratégico.

Aunque Anthrope enfatiza la seguridad (mejora de Claude y el fortalecimiento de las medidas de protección contra usos dañinos, como fraude y abuso), es probable que la decisión reaccione a la competencia: OpenAai y Google siguen siendo referencias en el sitio y requieren grandes cantidades de interacción para avanzar. Sin suficientes datos, las distancias en la raza de IA que observamos pueden vivir.

Cinco años en lugar de treinta días. Además del permiso de capacitación, Anthrope ha ampliado el período de retención para datos comunes para fines de mejora: Cinco años cuando el usuario acepta participarEn comparación con los 30 días, la regla cuando esta opción no se activa. La compañía también indica que los chats eliminados no están incluidos en la capacitación futura y que el Mensaje de retorno El enviado también se puede mantener. También significa que los procesos y herramientas automatizados para filtrar o disfrazar la información confidencial que no vende datos del usuario a terceros.

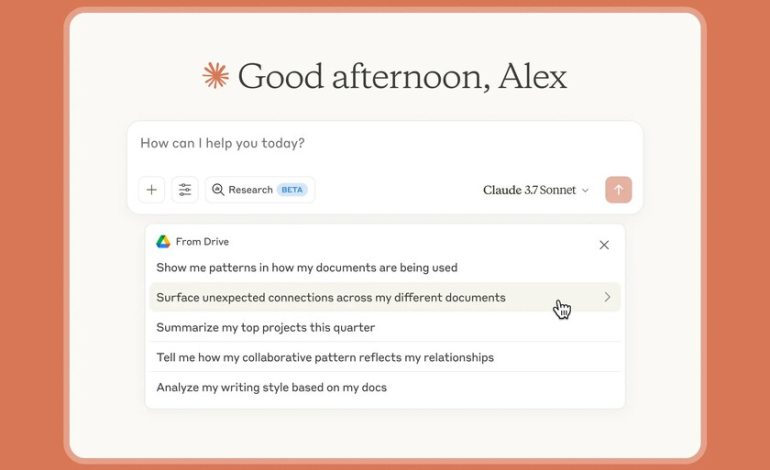

Fotos | Claude | Grabación de pantalla

En Xataka | Microsoft prefiere su propio 7, uno 10 de OpenAi. Los 13,000 millones invertidos en OpenAai solo tienen el significado de Gossies.